Ой! Зрештою, ніякої „кризи відтворюваності” в психологічній науці

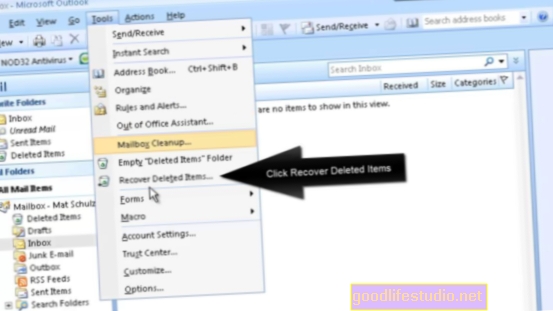

Але новаторська стаття, опублікована в серпні 2015 року 44 дослідниками «Оцінка відтворюваності психологічної науки» (Nosek et al., 2015), мабуть, мала деякі суттєві недоліки. Нова стаття припускає, що насправді в психології насправді немає "кризи відтворюваності".

Чотири дослідники з Гарвардського університету та Університету Вірджинії (Gilbert et al., 2016) опублікували свої висновки в Наука (їх веб-сайт з реплікації психології містить усі дані та матеріали). Вони вважають, що виявили три основні статистичні помилки в оригінальному дослідженні, які ставлять під сумнів його результати. Нові дослідники стверджують: "Справді, дані свідчать про протилежний висновок - що відтворюваність психологічної науки досить висока і насправді статистично не відрізняється від 100%".

На жаль

Оригінальне дослідження (Nosek et al., 2015) спробувало відтворити результати 100 експериментів, про які повідомлялося в роботах, опублікованих у 2008 році в трьох високопоставлених журналах з психології. Перша критика дослідження полягає в тому, що це не був рандомізований вибір психологічних досліджень. Натомість група Nosek обмежила свій вибір досліджень лише трьома журналами, що представляють мізерні дві дисципліни психології, залишаючи за собою такі основні сфери, як психологія розвитку та клінічна психологія. Тоді Nosek та співавт. використовували складний набір довільних правил та критеріїв, які фактично дискваліфікували понад 77 відсотків досліджень з трьох досліджених ними журналів.

Дослідження, які починаються з упередженої вибірки, неодмінно матимуть проблеми. Не починаючи з рандомізованої вибірки, дослідники вже допомогли створити основу для своїх невтішних висновків.

Давайте (суттєво) змінимо дослідження, які ми повторюємо

Навіть гірше, ніж починати з упередженої, нерандомізованої вибірки, було те, як дослідники насправді проводили реплікації. По-перше, дослідники запросили "певні групи повторити певні дослідження або вони дозволили командам вибрати дослідження, які вони хочуть повторити". Замість того, щоб випадковим чином призначати дослідників для реплікації досліджень, вони дозволяють дослідникам вибирати - враховуючи упередження кожного дослідника, щоб, можливо, вибрати дослідження, які, на їхню думку, були найменш тиражованими.

Нові дослідження іноді суттєво відрізнялись від старих досліджень, які вони намагалися повторити. Ось лише один (принаймні з десяток) прикладів того, як повторне дослідження спричинило значні ускладнення:

В іншому дослідженні студенти Білого в Стенфордському університеті переглянули відео, на якому четверо інших студентів Стенфорда обговорювали вступні правила в своєму університеті (Crosby, Monin, & Richardson, 2008). Троє дискутантів були білими, а один - чорним. Під час дискусії один із білих студентів висловив образливі коментарі щодо позитивних дій, і дослідники виявили, що спостерігачі значно довше дивились на чорношкірого студента, коли вважали, що він може почути коментарі інших, ніж тоді, коли він цього не міг. Хоча учасниками реплікаційного дослідження були студенти Амстердамського університету, вони переглянули те саме відео студентів Стенфорда, які розповідають (англійською мовою!) Про політику прийому в Стенфорд.

Чи могли студенти університету Амстердама справді зрозуміти, що таке позитивна дія в Америці взагалі, враховуючи значні культурні відмінності між американським та амстердамським суспільством? Дивно, але дослідники, які проводили реплікацію, сказали, що дослідження були "практично ідентичними" (і, природно, вони мають тенденцію стверджувати це, оскільки це їх вивчення). Проте оригінальні дослідники, визнаючи значні культурні відмінності в двох популяціях, не схвалили нове дослідження реплікації.

Гілберт та його колеги виявили подібну проблему не лише в одній, але й у багатьох дослідженнях реплікації. Дивно, що Nosek et al. вважали, що подібні суперечності не вплинуть на якість дослідження (або "вірність", як це називають дослідники). І все ж очевидно, що це суттєві якісні відмінності, які, безсумнівно, можуть вплинути на відтворюваність дослідження.

Нам потрібно більше енергії!

Носек та його колеги висловили кілька аргументів "солом'яної людини" за вибір дизайну, які Гілберт та ін. збити по черзі у відповідь. Висновок Гілберта та його колег?

Таким чином, жоден з аргументів [дослідників реплікації] не оспорює той факт, що автори [нового дослідження] використовували малопотужну конструкцію, і що (як показують наші аналізи даних ML2014) це, ймовірно, призвело до загального заниження реальної швидкості реплікації в їх даних.

Інші дослідники психології провели подібний експеримент з реплікацією ще в 2014 році (Klein et al., 2014). Використовуючи потужний дизайн, вони виявили, що більшість досліджень психології, які вони досліджували, повторювались - 11 з 13 експериментів були повторені. Щоб перевірити вплив менш потужної конструкції Nosek et al., Gilbert et al. за оцінками, показник реплікації дослідження 2014 року впав би з 85 відсотків до 34 відсотків. Істотна і показна різниця.

Отже, що ми насправді знаємо про відтворюваність психологічної науки?

Більше, ніж ми думали. З огляду на критику Гілберта та ін. Та безпричинну реакцію оригінальних дослідників, виглядає більш імовірним, що Nosek et al. дослідження було критично помилковим.

Здається, психологічна наука відтворюється більше, ніж ми думали - хороша новина як для науки, так і для психології.

Список літератури

Гілберт, Д., Кінг, Г., Петтігрю, С. та Вільсон, Т. (2016). Прокоментуйте „Оцінка відтворюваності психологічної науки”. Наука, 351, 1037a-1037b.

Гілберт та ін. (2016). Відповідь на відповідь нашого технічного коментаря на тему „Оцінка відтворюваності психологічної науки”.

Klein, RA, Ratliff, M Vianello, RB Adams Jr, Š Bahník, MJ Bernstein, et al. (2014). Дослідження варіацій реплікабельності: проект реплікації „Багато лабораторій”. Соціальна психологія, 45 років, 142-152

Носек та співавт. & Відкрита наукова співпраця. (2015). Оцінка відтворюваності психологічної науки. Наука, 349. DOI: 10.1126 / science.aac4716

Носек та співавт. (2016). Відповідь на коментар "Оцінка відтворюваності психологічної науки". Наука, 351, 1037. DOI: 10.1126 / science.aad9163